今天的AI前沿资讯。从Adobe的实时视频生成,到NVIDIA的光影魔法,再到Hugging Face的亲民微调教程,今天的科技界可谓是精彩纷呈。无论是专业开发者还是普通爱好者,都能在今天的快讯中找到属于自己的惊喜。让我们一起来看看都有哪些不容错过的亮点吧!

Adobe亮剑视频生成!Self Forcing模型实现4090显卡实时出片,人人都是特效师

Adobe最新发布的Self Forcing模型,标志着实时视频生成技术的新突破。该模型基于Wang 2.1架构,实现了在单张RTX 4090消费级显卡上的流畅运行,并已开放线上试用,让更多创作者能够亲身体验其强大的功能。

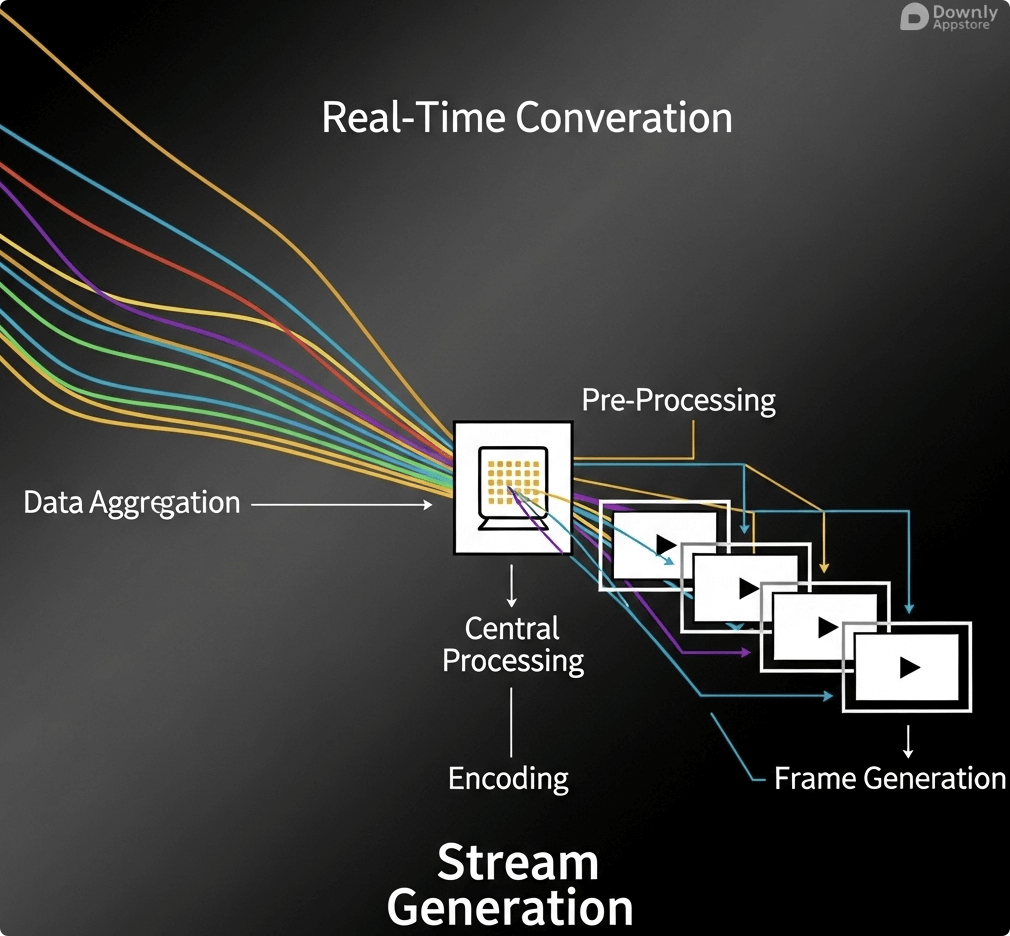

Self Forcing 核心技术解析

Adobe推出的Self Forcing模型,其技术核心是建立在先进的Wang 2.1架构之上。这一架构专为流式视频生成进行了优化,意味着模型能够一边接收输入指令,一边连续不断地生成视频帧,从而达到“实时”的效果。这与传统模型需要等待完整指令后才能开始渲染的方式截然不同,为即时互动和直播等场景提供了可能。

硬件亲民化的重要一步

以往,高质量的AI视频生成往往需要庞大的计算资源,通常是数据中心级别的服务器集群。而Self Forcing模型最大的亮点之一,就是它对硬件的优化。官方宣称,该模型可以在单张NVIDIA RTX 4090显卡上高效运行。这使得拥有高端PC的个人开发者、设计师和内容创作者,也能够接触并使用前沿的AI视频生成技术,极大地降低了技术门槛。

在线试用与未来展望

为了让更多用户感受Self Forcing的魅力,Adobe已经提供了在线试用入口。用户可以通过官方渠道访问并体验这一模型的实时生成能力。这一举措不仅展示了Adobe对自身技术的信心,也预示着AI视频生成工具将加速融入普通人的创作流程中,未来我们可能会看到更多由AI实时生成的短视频、直播背景甚至互动电影。 试用地址

挑战Whisper霸主地位!Kyutai发布开源极速STT模型,实时语音转写新选择

法国AI初创公司Kyutai推出了一款名为Kyutai Speech-To-Text(STT)的开源模型,以其惊人的速度和超越Whisper Large v3的性能,为语音转文本领域带来了新的标杆。该模型特别优化了实时流式处理,并提供了针对不同需求的版本。

性能卓越 超越Whisper

Kyutai Speech-To-Text模型在发布之初就将目标对准了行业标杆OpenAI的Whisper。根据官方公布的数据,其纯英语的2.6B参数版本,在多项评测基准上表现优于Whisper Large v3。这不仅体现在转写的准确率上,更体现在其“极速”的特性上,无论是处理已有的音频文件(批量推理),还是进行实时的语音流转写(流式推理),都展现出了顶级的性能。

两种模型版本 各有侧重

为了满足不同场景的需求,Kyutai贴心地推出了两个版本:

- 2.6B参数模型 这是一个纯英语模型,性能强劲,是追求最高转写质量和速度的用户的首选。

- 1B参数模型 这是一个更轻量级的双语模型,专为英语和法语的实时语音聊天场景优化。它在保持较低延迟的同时,实现了高效的双语识别,非常适合跨语言交流工具的开发。

开源精神与应用前景

Kyutai STT模型选择完全开源,开发者可以在其官方渠道(如Hugging Face)轻松获取模型和相关代码。这意味着任何开发者都可以自由地使用、修改和集成这个强大的工具。尽管目前模型暂不支持中文,但其出色的架构和性能为多语言语音识别领域注入了新的活力,未来有望通过社区的力量扩展到更多语种。

后期制作的魔法!NVIDIA UniRelight一键重塑视频光影,废片变大片

NVIDIA AI团队再次展示其技术实力,推出名为UniRelight的通用视频重照明技术。这项基于扩散模型的技术,能够仅凭单张参考图或一段视频,就对目标视频实现逼真、高质量的动态光影重塑,为影视后期和内容创作带来了革命性的工具。

UniRelight 是什么

UniRelight是一项创新的“通用重照明”技术。简单来说,它允许创作者在视频拍摄完成之后,像编辑照片一样,任意改变视频中的光照效果。无论是想把白天变成黑夜,还是为场景添加一盏虚拟的、动态移动的灯光,UniRelight都能通过AI计算,生成符合物理规律的、自然的光影变化,极大地丰富了后期创作的可能性。

扩散模型的魔力

这项技术的核心驱动力是扩散模型(Diffusion Model)。模型通过学习海量数据,理解了光线与物体表面材质、场景深度之间的复杂关系。当用户提供一张参考图片(例如一张日落的照片)时,UniRelight就能“理解”其中的光照风格,并将其应用到目标视频的每一帧中,同时确保光影的连续性和真实感。

应用场景与开源计划

UniRelight的应用前景极为广阔。对于电影制作,它可以大幅降低现场布光的成本和难度;对于短视频创作者,它可以轻松为普通视频增添“电影感”;对于游戏开发,它可以用于生成更真实的环境光照。NVIDIA已经表示,该技术的代码即将开源,这意味着它将很快成为广大开发者和创作者可以使用的强大工具。目前,官方网站已展示了大量惊艳的效果案例供业界参考。

一张图、一段话,AI帮你拍广告!HeyGen新功能让产品视频制作进入“傻瓜”模式

AI视频生成平台HeyGen再次降低内容创作门槛,推出了全新的AI广告生成工具。现在,用户仅需三步——上传产品图、选择虚拟形象、输入文案,即可快速生成一段专业的带货或产品介绍视频,彻底改变了传统营销视频的制作模式。

三步搞定产品视频

HeyGen新推出的产品植入功能,主打的就是极致的简洁与高效。整个创作流程被简化为三个核心步骤:

- 提供产品照片 用户上传自己需要推广的产品的清晰图片。

- 选择人物形象 在HeyGen提供的多种虚拟形象中,选择一个符合品牌调性的“代言人”。

- 输入文字脚本 将产品介绍、广告语等文案输入系统。

完成这三步后,AI会自动将产品照片与虚拟形象融合,并根据脚本生成一段口型精准、动作自然的介绍视频。

AI如何简化营销流程

这项功能背后,是成熟的AI虚拟人技术和图像处理技术的结合。AI不仅能让虚拟人自然地“说话”,还能智能地将静态的产品图片融入到动态的视频场景中,仿佛虚拟人真的手持产品在进行介绍。对于中小型企业、电商卖家或个人品牌来说,这意味着无需昂贵的拍摄团队、演员和场地,就能快速、低成本地批量生产高质量的营销视频。

为谁而生

这个工具的主要受益者是那些需要大量视频内容但预算有限的营销人员和商家。它极大地缩短了从创意到成品的周期,使得测试不同的广告文案、产品卖点和视觉风格变得轻而易举。可以说,HeyGen正在让专业的视频广告制作,变得像制作PPT一样简单。

10GB显存就能“炼丹”!Hugging Face发布FLUX.1-dev平民级微调教程

人人都能微调大模型不再是梦想。Hugging Face近日发布官方教程,手把手教你如何利用QLoRA技术,在仅有10GB显存的消费级显卡上,对强大的文生图模型FLUX.1-dev进行高效微调,极大地降低了AI模型定制化的门槛。

主角 FLUX.1-dev模型

FLUX.1-dev 是一个新兴的、强大的文本到图像生成模型。与之前的扩散模型不同,它采用了新的架构,旨在更深刻地理解文本提示的复杂性和细微差别,从而生成更贴合描述的图像。能够对这样的前沿模型进行微调,意味着用户可以训练出具有自己独特风格的“专属AI画家”。

核心技术 QLoRA

实现低门槛微调的关键在于QLoRA(Quantized Low-Rank Adaptation)技术。简单来说,它是一种“四两拨千斤”的训练方法。它通过量化和低秩适配技术,在不牺牲太多性能的前提下,大幅减少了模型微调过程中所需要的显存。Hugging Face的教程正是利用了QLoRA,将原本需要专业级硬件才能进行的任务,成功地运行在了仅有10GB显存的消费级显卡上,如RTX 3060 (12GB) 或 RTX 4060 Ti等。

教程详解与实践意义

Hugging Face发布的这篇官方教程,详细介绍了整个微调过程的每一步,包括环境配置、加载模型、准备数据集,以及如何使用diffusers库来应用QLoRA进行训练。这篇教程的意义非凡,它为广大的AI爱好者、艺术家和独立开发者打开了一扇大门,让他们能够用得起的硬件,去定制和探索最先进的AI模型,从而催生出更多个性化、多样化的AI艺术作品和应用。

相关推荐

2025 AI 技术峰会

AI 实战课程

热门工具

AI 助手

智能对话,提升效率

智能图像处理

一键美化,智能修图

AI 翻译

多语言实时翻译

评论 (0)

暂无评论,快来发表第一条评论吧!